前提

1完成了稳定解析和数据清洗

2训练和预测通路构建完成

3选择了合适的评估方式

模型结构选择

1使用历史模型结构

2使用相似问题的论文的模型

优化器选择

1使用相似问题的优化器

2有更多超参数的优化器调优更复杂

3初始阶段通常选择简单的优化器SGD或者Adam

4Adam和NAdam比SGD更通用

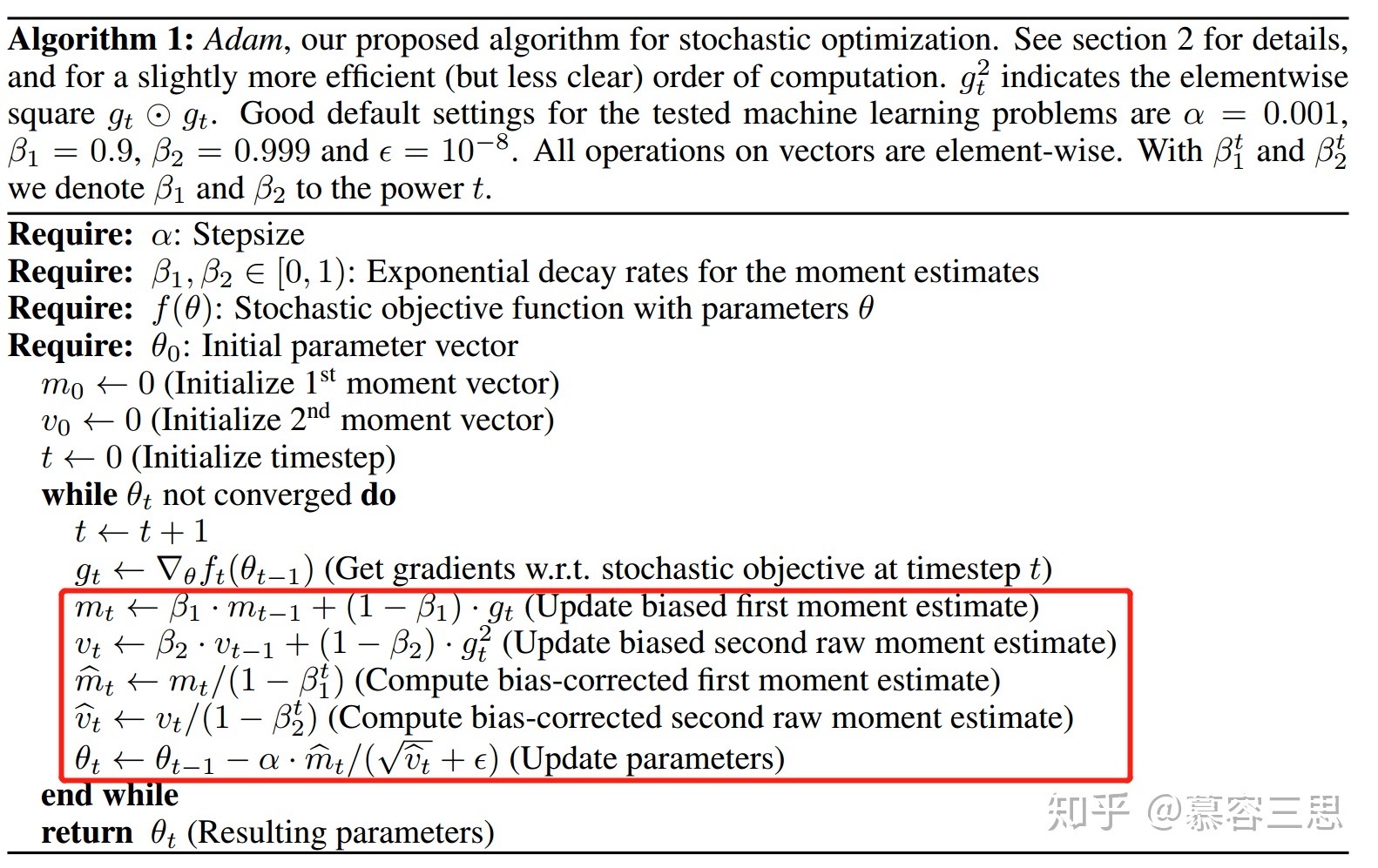

Adam工作原理

a计算梯度一级矩估计: 计算上一次梯度和当前梯度的加权平均

b计算梯度平方的一阶矩估计,计算上一次梯度平方和当前梯度平方的加权平均

c计算偏差修正后的梯度一阶矩估计和梯度平方一阶矩估计

5调参重要性lr>b1>e>b2

5调参重要性lr>b1>e>b2

batchsize

理论上机器承受的最大batch

1大batch更容易过拟合需要更强大的正则,小batch方差较大

Trick

1 模型参数移动平均

2 对抗学习

3 Celoss变为Smooth损失

FEATURED TAGS

c语言

c++

面向对象

指针

容器

python

函数

数据结构

回归

损失函数

神经网络

机器学习

似然函数

极大似然

标准化

深度学习

卷积网络

参数估计

beta分布

数据处理

gradio

模型工程化

网页

模型加速工具

c++实现

变量

占位符

tensorflow

线性回归

学习tensorflow

HMM

RNN

强化学习

LSTM

pandas

不定长序列损失

pytorch

目标检测

RPN

非极大值抑制

ROIpooling

VGG16

Transformer

BERT

Python

装饰器

方法

Pytorch

FPN

图像分类

CNN

多模态

生成

GPT

Tranformer

生成模型

audio